대규모로 기기 내 머신러닝 (ML)을 테스트하고 벤치마킹하기 위한 AI Edge의 Google Cloud 솔루션입니다.

다양한 휴대기기에서 ML 모델 성능을 최적화하는 것은 쉽지 않을 수 있습니다. 수동 테스트는 느리고 비용이 많이 들며 대부분의 개발자가 액세스할 수 없으므로 실제 모델 성능이 불확실해집니다. Google AI Edge Portal은 다양한 휴대기기에서 LiteRT 모델 벤치마킹을 사용 설정하여 이 문제를 해결하므로 개발자가 대규모 ML 모델 배포에 가장 적합한 구성을 찾을 수 있습니다.

모바일 ML 배포 최적화

다양한 하드웨어 환경에서 테스트 주기를 간소화하고 가속화: 수백 대의 대표적인 휴대기기에서 모델 성능을 몇 분 만에 손쉽게 평가할 수 있습니다.

사전 예방적으로 모델 품질을 보장하고 문제를 조기에 파악: 배포 전에 하드웨어별 성능 변동 또는 회귀 (예: 특정 칩셋 또는 메모리 제약 기기)를 파악합니다.

기기 테스트 비용 절감 및 최신 하드웨어 액세스: 자체 실험실을 유지하는 데 드는 비용과 복잡성 없이 다양하고 지속적으로 증가하는 실제 기기 (현재 다양한 Android OEM의 100개가 넘는 기기 모델)에서 테스트할 수 있습니다.

강력한 데이터 기반 의사 결정 및 비즈니스 인텔리전스 활용: Google AI Edge Portal은 풍부한 실적 데이터와 비교 정보를 제공하여 모델 최적화를 안내하고 배포 준비 상태를 검증하는 데 필요한 중요한 비즈니스 인텔리전스를 제공합니다.

벤치마크 예:

Google AI Edge Portal을 사용하여 LiteRT 모델을 벤치마킹하는 방법

업로드 및 구성: UI를 통해 모델 파일을 업로드하거나 Google Cloud Storage 버킷에서 모델 파일을 가리킵니다.

가속기 선택: CPU 또는 GPU에 대한 테스트를 지정합니다 (자동 CPU 대체 포함). NPU 지원은 향후 출시 버전에서 계획되어 있습니다.

기기 선택: 필터(기기 등급, 브랜드, 칩셋, RAM)를 사용하여 다양한 풀에서 대상 기기를 선택하거나 편리한 바로가기를 사용하여 선별된 목록을 선택합니다.

100대 이상의 기기에서 새 벤치마크 작업을 만듭니다. (참고: GIF는 간결성을 위해 가속되고 수정되었습니다.)

그런 다음 작업을 제출하고 완료될 때까지 기다립니다. 준비가 되면 양방향 대시보드에서 결과를 살펴봅니다.

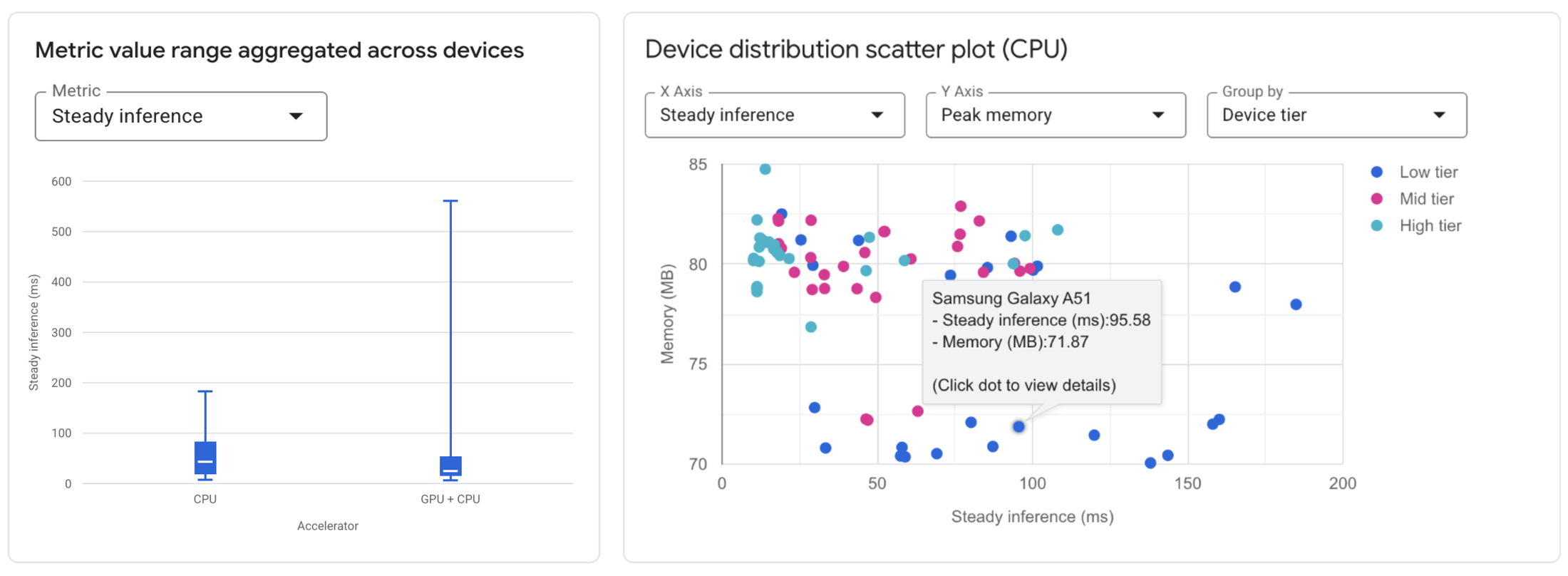

구성 비교: 테스트된 모든 기기에서 서로 다른 가속기를 사용할 때 성능 측정항목 (예: 평균 지연 시간, 최대 메모리)이 어떻게 다른지 빠르게 시각화합니다.

기기 영향 분석: 선택한 다양한 기기에서 특정 모델 구성이 어떻게 실행되는지 확인합니다. 히스토그램과 분산형 차트를 사용하여 기기 특성과 관련된 성능 변동을 빠르게 식별합니다.

세부 측정항목: 각 개별 기기의 하드웨어 사양과 함께 특정 측정항목(초기화 시간, 추론 지연 시간, 메모리 사용량)을 보여주는 정렬 가능한 세부 표에 액세스합니다.

대화형 대시보드에서 벤치마크 결과를 확인합니다. (참고: GIF는 간결성을 위해 가속되고 수정되었습니다.)

Google AI Edge Portal 비공개 미리보기 참여하기

Google AI Edge Portal은 허용 목록에 추가된 Google Cloud 고객을 대상으로 비공개 미리보기 버전으로 제공됩니다. 이 비공개 미리보기 기간에는 미리보기 약관에 따라 무료로 액세스할 수 있습니다.

이 미리보기는 LiteRT로 모바일 ML 애플리케이션을 빌드하고 다양한 Android 하드웨어에서 안정적인 벤치마킹 데이터가 필요하며 제품의 미래를 형성하는 데 도움이 되는 의견을 제공하고자 하는 개발자와 팀에 적합합니다. 액세스 권한을 요청하려면 여기에서 가입 양식을 작성하여 관심을 표현하세요. 허용 목록을 통해 액세스 권한이 부여됩니다.