2025 年 4 月 9 日

在 Langbase 上使用 Gemini Flash,打造低成本、高總處理量的 AI 代理

建構能夠自主管理作業和外部工具的 AI 代理程式,通常需要克服整合和基礎架構方面的障礙。Langbase 可免除管理這些基礎複雜性的負擔,提供平台來建立及部署由 Gemini 等模型支援的無伺服器 AI 代理程式,完全不需要架構。

自 Gemini Flash 發布以來,Langbase 使用者很快就發現,使用這些輕量型模型打造代理程式體驗,在效能和成本方面都具有優勢。

運用 Gemini Flash 實現可擴充性,並加快 AI 代理程式的運作速度

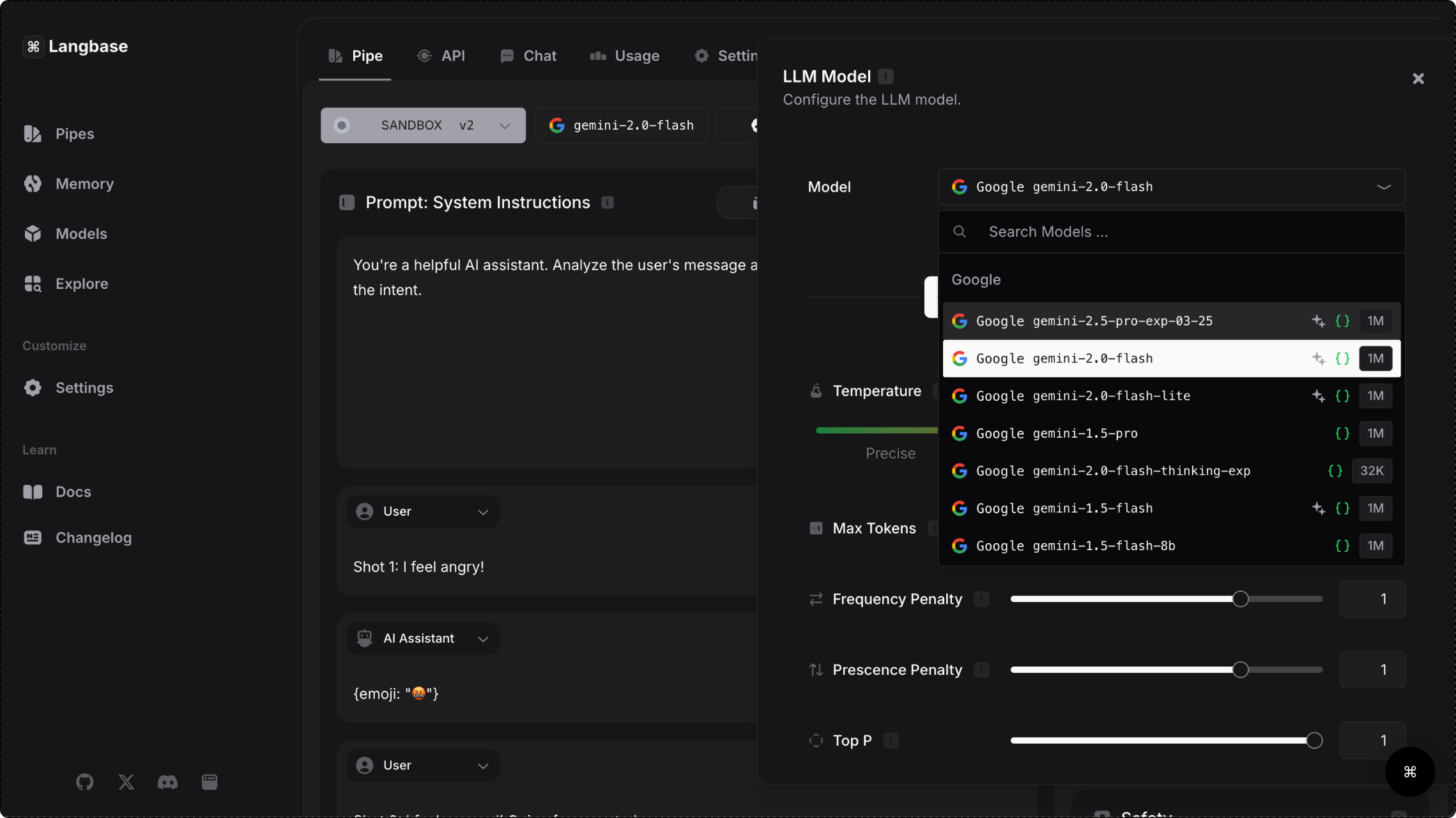

Langbase 平台透過 Gemini API 提供 Gemini 模型存取權,讓使用者選擇能處理複雜工作和大量資料的快速模型。延遲時間短是提供順暢即時體驗的關鍵,因此 Gemini Flash 模型系列特別適合用來建構面向使用者的代理程式。

除了回應速度提升 28% 外,平台使用者在作業中使用 Gemini 1.5 Flash 時,成本也減少了 50%,輸送量則增加了 78%。Gemini Flash 模型可處理大量要求,且不會影響效能,因此非常適合用於高需求量的應用程式,例如社群媒體內容創作、研究論文摘要和醫療文件主動分析等用途。

31.1 個權杖/秒

與同類模型相比,Flash 的處理量高出 78%

7.8x

與同類模型相比,Flash 的脈絡窗口更大

28%

與同類模型相比,Flash 的回應速度更快

50%

與同類模型相比,Flash 的成本較低

- 資料來源:Langbase 網誌

Langbase 如何簡化代理程式開發作業

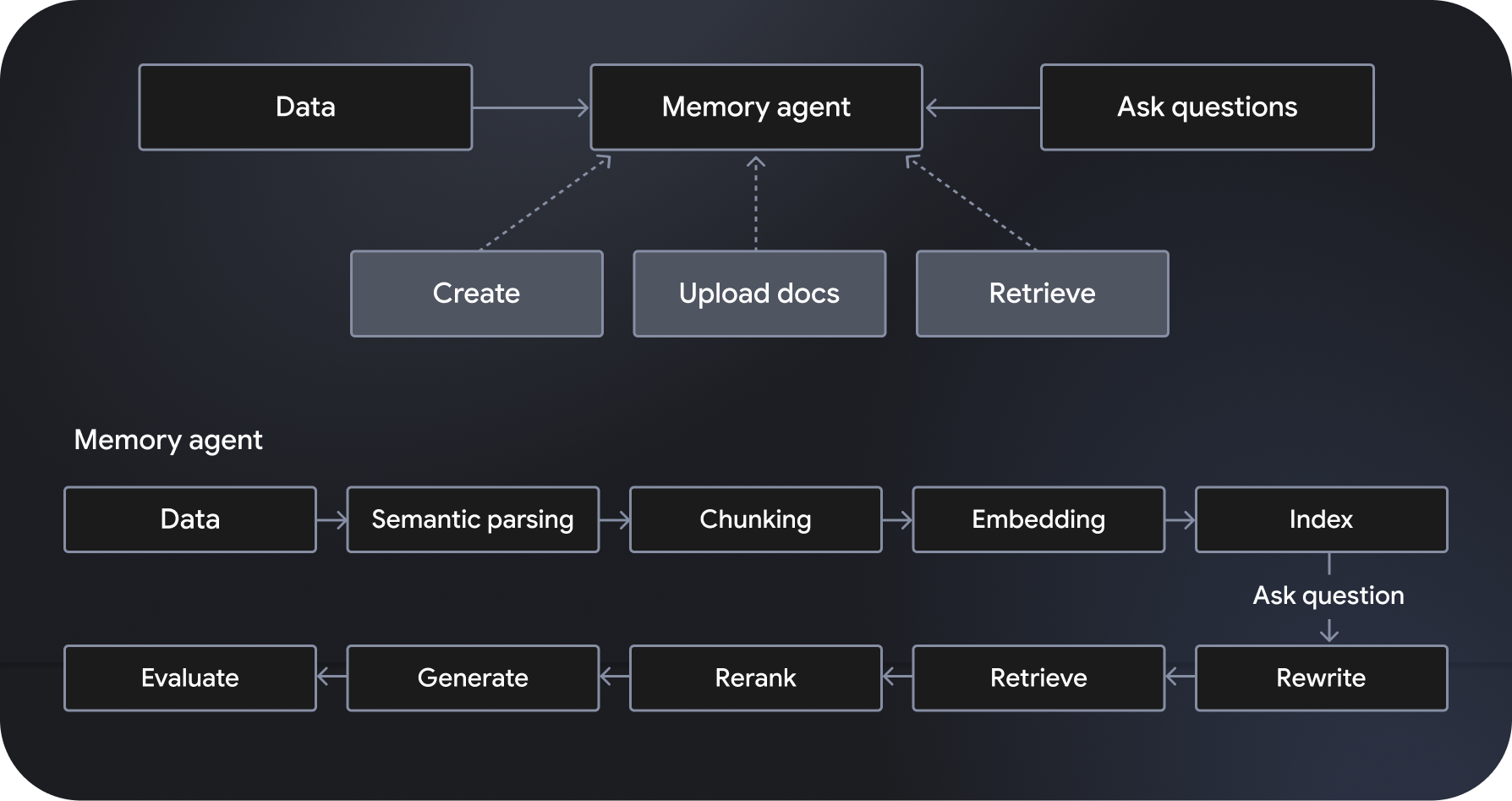

Langbase 是無伺服器、可組合的 AI 代理開發及部署平台,可建立無伺服器 AI 代理。這項服務提供全代管、可擴充的語意檢索增強生成 (RAG) 系統,又稱為「記憶體代理程式」。其他功能包括工作流程自動化調度管理、資料管理、使用者互動處理,以及與外部服務整合。

「管道代理程式」搭載 Gemini 2.0 Flash 等模型,會遵守並執行指定指令,還能存取網頁搜尋和網頁檢索等強大工具。另一方面,記憶體代理程式會動態存取相關資料,生成有憑有據的回覆。開發人員可透過 Langbase 的 Pipe 和 Memory API,將強大的推理能力連結至新的資料來源,擴展 AI 模型的知識和實用性,建構強大的功能。