NGÀY 9 THÁNG 4 NĂM 2025

Các tác nhân AI có thông lượng cao, chi phí thấp với Gemini Flash trên Langbase

Việc xây dựng các tác nhân AI có khả năng tự quản lý hoạt động và các công cụ bên ngoài thường đòi hỏi bạn phải vượt qua những trở ngại về việc tích hợp và cơ sở hạ tầng. Langbase giúp bạn không phải quản lý những điểm phức tạp cơ bản này, đồng thời cung cấp một nền tảng để tạo và triển khai tác nhân AI không cần máy chủ dựa trên các mô hình như Gemini mà không cần khung.

Kể từ khi Gemini Flash ra mắt, người dùng Langbase đã nhanh chóng nhận ra những lợi thế về hiệu suất và chi phí khi sử dụng các mô hình gọn nhẹ này cho trải nghiệm dựa trên tác nhân.

Đạt được khả năng mở rộng và các tác nhân AI nhanh hơn nhờ Gemini Flash

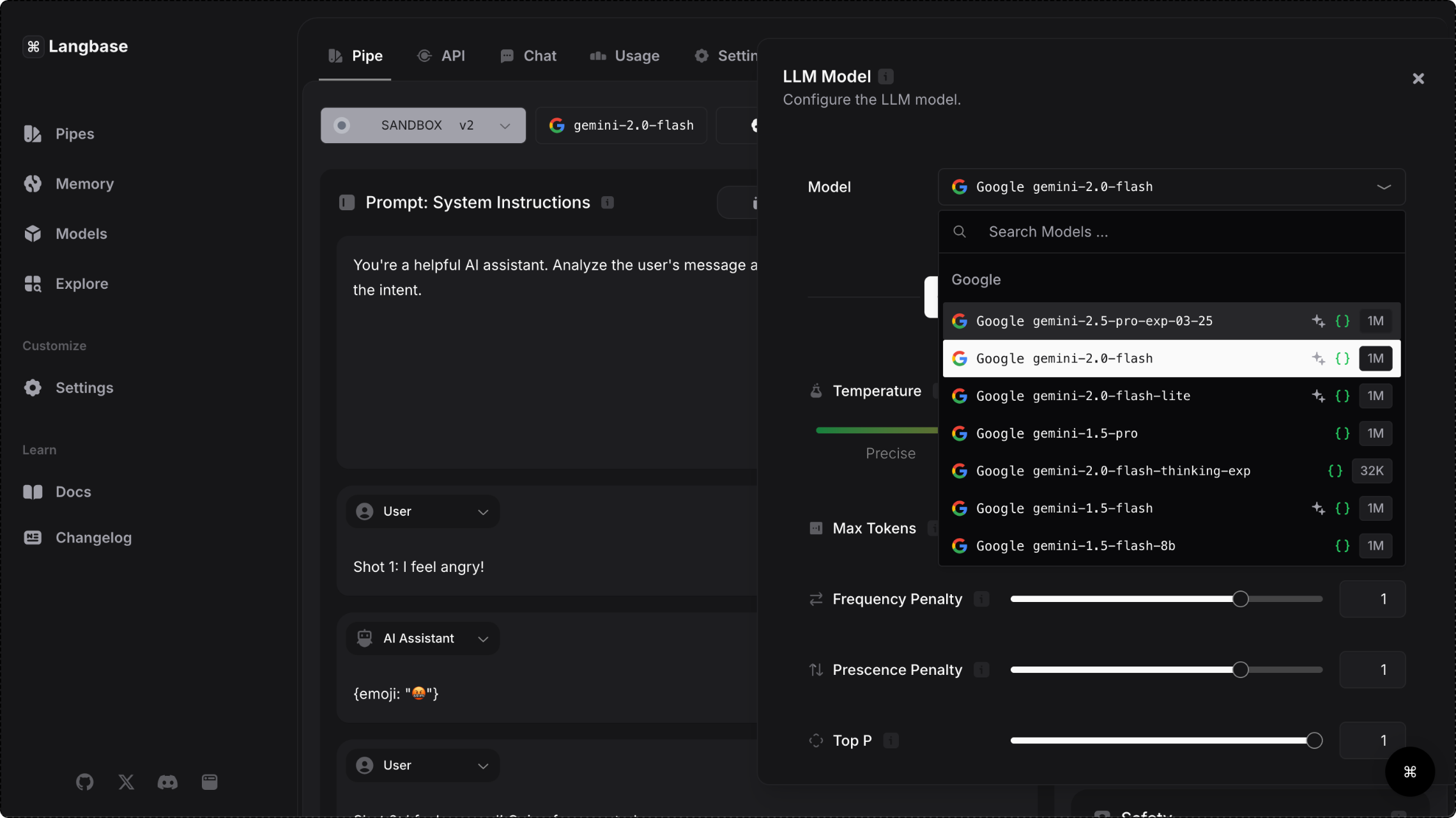

Nền tảng Langbase cung cấp quyền truy cập vào các mô hình Gemini thông qua Gemini API, cho phép người dùng chọn các mô hình nhanh có thể xử lý các tác vụ phức tạp và xử lý lượng lớn dữ liệu. Vì độ trễ thấp là yếu tố quan trọng để mang lại trải nghiệm mượt mà theo thời gian thực, nên họ mô hình Gemini Flash đặc biệt phù hợp để xây dựng các tác nhân tương tác với người dùng.

Ngoài thời gian phản hồi nhanh hơn 28%, người dùng nền tảng còn giảm 50% chi phí và tăng 78% thông lượng cho các hoạt động khi sử dụng Gemini 1.5 Flash. Khả năng xử lý một lượng lớn yêu cầu mà không ảnh hưởng đến hiệu suất khiến các mô hình Gemini Flash trở thành lựa chọn phù hợp cho các ứng dụng có nhu cầu cao trong các trường hợp sử dụng như tạo nội dung trên mạng xã hội, tóm tắt bài nghiên cứu và phân tích chủ động tài liệu y tế.

31,1 mã thông báo/giây

Thông lượng cao hơn 78% với Flash so với các mô hình tương đương

7,8x

cửa sổ ngữ cảnh lớn hơn với Flash so với các mô hình tương đương

28%

Thời gian phản hồi nhanh hơn với Flash so với các mô hình tương đương

50%

Chi phí thấp hơn so với các mẫu tương đương

- Nguồn: Blog Langbase

Cách Langbase đơn giản hoá quy trình phát triển tác nhân

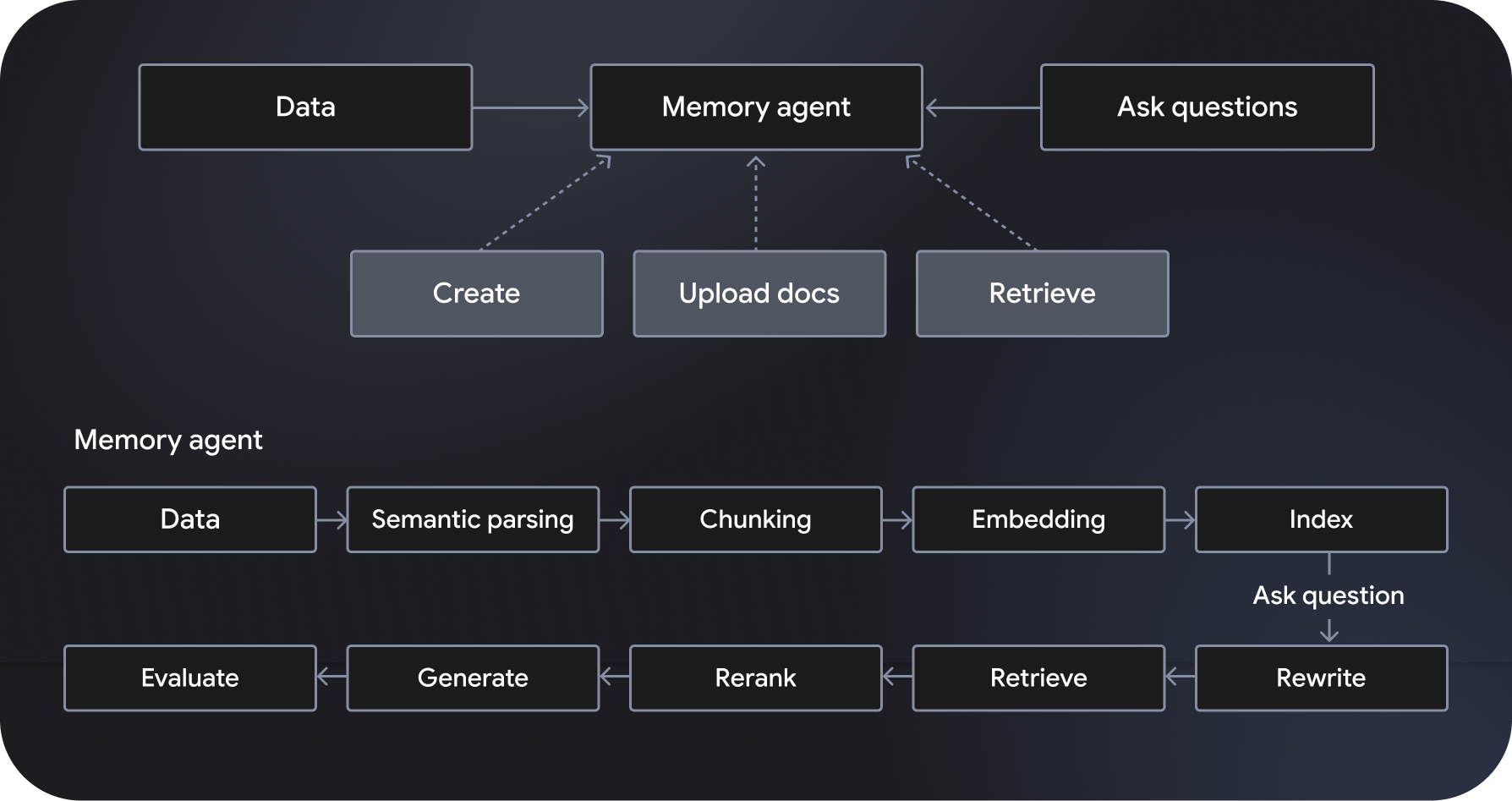

Langbase là một nền tảng phát triển và triển khai tác nhân AI có thể kết hợp và không máy chủ, cho phép tạo các tác nhân AI không máy chủ. Đây là hệ thống tạo tăng cường truy xuất ngữ nghĩa (RAG) có khả năng mở rộng và được quản lý hoàn toàn, còn được gọi là "tác nhân bộ nhớ". Các tính năng bổ sung bao gồm điều phối quy trình làm việc, quản lý dữ liệu, xử lý tương tác người dùng và tích hợp với các dịch vụ bên ngoài.

Dựa trên các mô hình như Gemini 2.0 Flash, "tác nhân dạng ống dẫn" tuân thủ và hành động theo các chỉ dẫn cụ thể, đồng thời có quyền truy cập vào các công cụ mạnh mẽ, bao gồm cả tính năng tìm kiếm và thu thập thông tin trên web. Mặt khác, các tác nhân dựa trên bộ nhớ sẽ truy cập linh hoạt vào dữ liệu liên quan để tạo ra các câu trả lời có căn cứ. Pipe và Memory API của Langbase cho phép nhà phát triển tạo các tính năng mạnh mẽ bằng cách kết nối khả năng suy luận mạnh mẽ với các nguồn dữ liệu mới, mở rộng kiến thức và tiện ích của các mô hình AI.

Bằng cách tự động hoá các quy trình phức tạp, nâng cao hiệu quả của quy trình làm việc và mang đến cho người dùng trải nghiệm phù hợp với từng cá nhân, các tác nhân AI mở ra nhiều khả năng cho các ứng dụng mạnh mẽ hơn. Sự kết hợp giữa khả năng suy luận mạnh mẽ, chi phí thấp và tốc độ nhanh hơn khiến các mô hình Gemini Flash trở thành lựa chọn ưu tiên cho người dùng Langbase. Khám phá nền tảng này để bắt đầu xây dựng và triển khai tác nhân AI có hiệu suất cao và khả năng mở rộng.