30 ottobre 2024

Portare gli agenti AI in produzione con l'API Gemini

La creazione e il deployment di agenti AI è una frontiera entusiasmante, ma la gestione di questi sistemi complessi in un ambiente di produzione richiede un'osservabilità solida. AgentOps, un SDK Python per il monitoraggio degli agenti, il monitoraggio dei costi LLM, il benchmarking e altro ancora, consente agli sviluppatori di portare i propri agenti dal prototipo alla produzione, soprattutto se abbinato alla potenza e all'efficacia in termini di costi dell'API Gemini.

Il vantaggio di Gemini

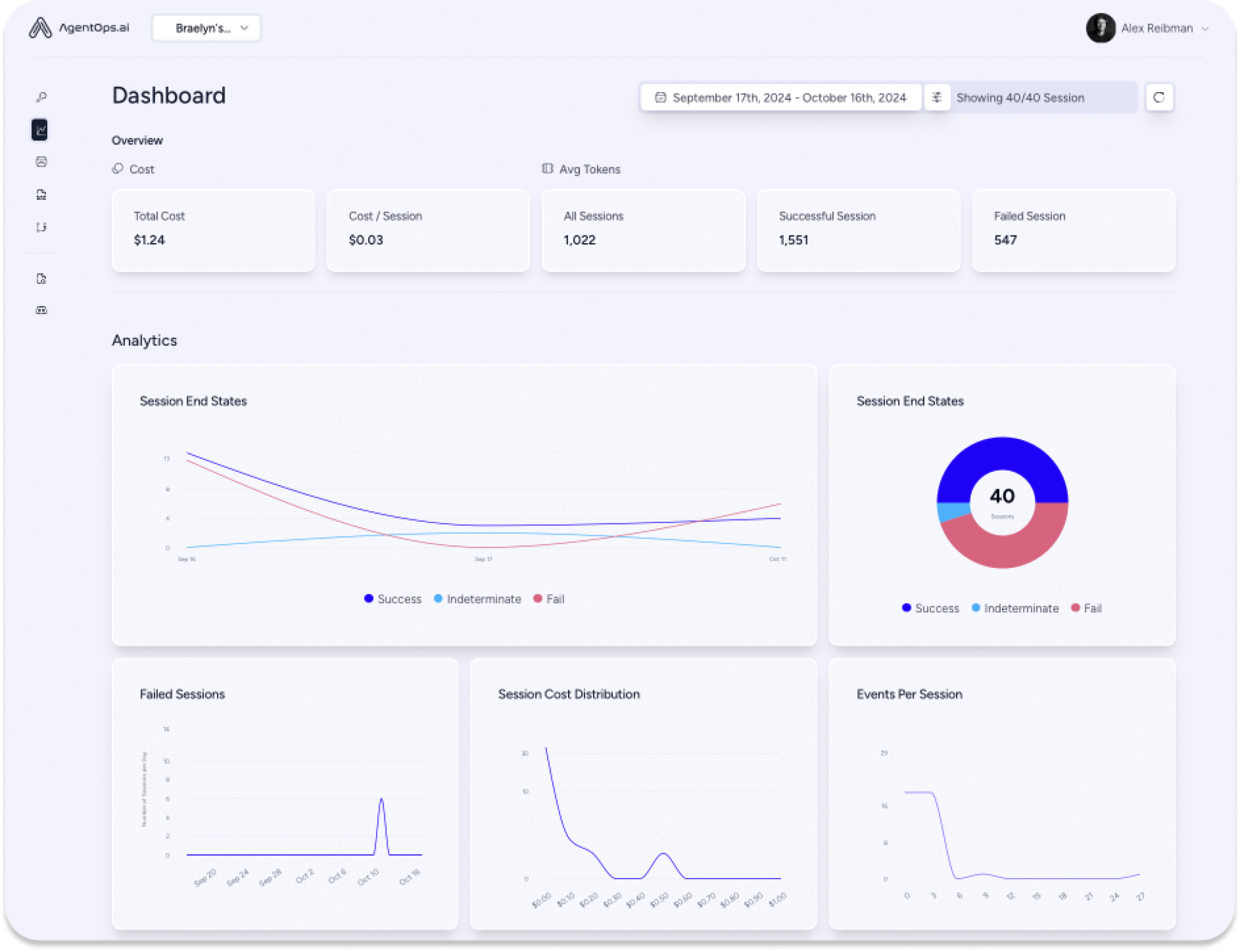

Adam Silverman, COO di Agency AI, il team che ha creato AgentOps, spiega che il costo è un fattore fondamentale per le aziende che implementano agenti AI su larga scala. "Abbiamo visto aziende spendere 80.000 $al mese per chiamate LLM. Con Gemini 1.5, per lo stesso output sarebbero stati necessari alcuni migliaia di dollari".

Questa convenienza, combinata con le potenti funzionalità di comprensione e generazione del linguaggio di Gemini, lo rende la scelta ideale per gli sviluppatori che creano agenti AI sofisticati. "Gemini 1.5 Flash ci offre una qualità paragonabile a quella dei modelli più grandi, a una frazione del costo e con una velocità incredibile", afferma Silverman. In questo modo, gli sviluppatori possono concentrarsi sulla creazione di flussi di lavoro degli agenti complessi e in più passaggi senza preoccuparsi di costi eccessivi.

"Abbiamo visto che le esecuzioni di singoli agenti con altri fornitori di LLM costano oltre 500 $per esecuzione. Queste stesse esecuzioni con Gemini (1.5 Flash-8B) costano meno di 50 $.”

Alimentazione degli agenti AI

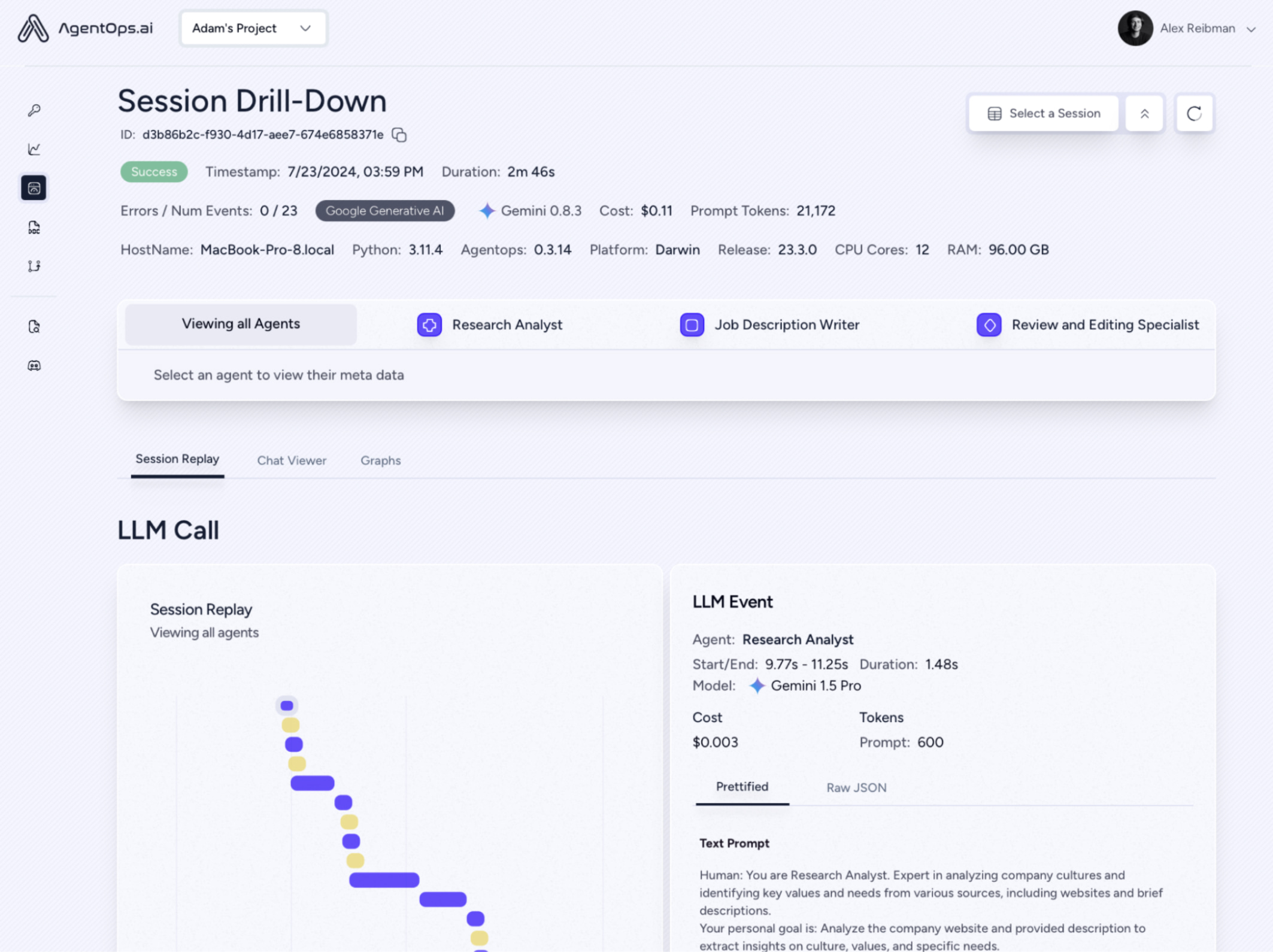

AgentOps acquisisce i dati su ogni interazione dell'agente, non solo sulle chiamate LLM, fornendo una visione completa del funzionamento dei sistemi multi-agente. Questo livello di dettaglio granulare è essenziale per i team di ingegneria e conformità, in quanto offre informazioni cruciali per il debug, l'ottimizzazione e le tracce di controllo.

L'integrazione dei modelli Gemini con AgentOps è incredibilmente semplice e spesso richiede solo pochi minuti utilizzando LiteLLM. Gli sviluppatori possono ottenere rapidamente visibilità sulle chiamate API Gemini, monitorare i costi in tempo reale e garantire l'affidabilità dei loro agenti in produzione.

Prospettive future

AgentOps si impegna a supportare gli sviluppatori di agenti man mano che scalano i loro progetti. L'AI per le agenzie aiuta le aziende a gestire le complessità della creazione di agenti scalabili e a costi contenuti, consolidando ulteriormente la proposta di valore della combinazione di AgentOps con l'API Gemini. Come sottolinea Silverman, "Sta spingendo gli sviluppatori più attenti al prezzo a creare agenti".

Per gli sviluppatori che stanno valutando l'utilizzo di Gemini, il consiglio di Silverman è chiaro: "Provalo e rimarrai impressionato".