Tugas Pengenal Gestur MediaPipe memungkinkan Anda mengenali gestur tangan secara real time, dan memberikan hasil gestur tangan yang dikenali dan penanda tangan dari tangan yang terdeteksi. Petunjuk ini menunjukkan cara menggunakan Pengenal Gestur dengan aplikasi Python.

Anda dapat melihat cara kerja tugas ini dengan melihat Demo web Untuk mengetahui informasi selengkapnya tentang kemampuan, model, dan opsi konfigurasi tugas ini, lihat Ringkasan.

Contoh kode

Kode contoh untuk Pengenal Gestur memberikan implementasi lengkap tugas ini di Python sebagai referensi Anda. Kode ini membantu Anda menguji tugas ini dan mulai membangun pengenal gestur tangan Anda sendiri. Anda dapat melihat, menjalankan, dan mengedit kode contoh Pengenal Gestur hanya menggunakan browser web.

Jika Anda menerapkan Pengenal Gestur untuk Raspberry Pi, lihat aplikasi contoh Raspberry Pi.

Penyiapan

Bagian ini menjelaskan langkah-langkah utama untuk menyiapkan lingkungan pengembangan dan project kode Anda secara khusus untuk menggunakan Pengenal Gestur. Untuk informasi umum tentang menyiapkan lingkungan pengembangan untuk menggunakan tugas MediaPipe, termasuk persyaratan versi platform, lihat Panduan penyiapan untuk Python.

Paket

Tugas MediaPipe Gesture Recognizer memerlukan paket mediapipe PyPI. Anda dapat menginstal dan mengimpor dependensi ini dengan cara berikut:

$ python -m pip install mediapipe

Impor

Impor class berikut untuk mengakses fungsi tugas Pengenal Gestur:

import mediapipe as mp

from mediapipe.tasks import python

from mediapipe.tasks.python import vision

Model

Tugas MediaPipe Gesture Recognizer memerlukan paket model terlatih yang kompatibel dengan tugas ini. Untuk informasi selengkapnya tentang model terlatih yang tersedia untuk Pengenal Gestur, lihat bagian Model ringkasan tugas.

Pilih dan download model, lalu simpan di direktori lokal:

model_path = '/absolute/path/to/gesture_recognizer.task'

Tentukan jalur model dalam parameter Nama Model, seperti yang ditunjukkan di bawah ini:

base_options = BaseOptions(model_asset_path=model_path)

Membuat tugas

Tugas Pengenal Gestur MediaPipe menggunakan fungsi create_from_options untuk menyiapkan

tugas. Fungsi create_from_options menerima nilai untuk opsi konfigurasi yang akan ditangani. Untuk informasi selengkapnya tentang opsi konfigurasi, lihat

Opsi konfigurasi.

Kode berikut menunjukkan cara mem-build dan mengonfigurasi tugas ini.

Contoh ini juga menunjukkan variasi konstruksi tugas untuk gambar, file video, dan streaming video live.

Gambar

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions GestureRecognizer = mp.tasks.vision.GestureRecognizer GestureRecognizerOptions = mp.tasks.vision.GestureRecognizerOptions VisionRunningMode = mp.tasks.vision.RunningMode # Create a gesture recognizer instance with the image mode: options = GestureRecognizerOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.IMAGE) with GestureRecognizer.create_from_options(options) as recognizer: # The detector is initialized. Use it here. # ...

Video

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions GestureRecognizer = mp.tasks.vision.GestureRecognizer GestureRecognizerOptions = mp.tasks.vision.GestureRecognizerOptions VisionRunningMode = mp.tasks.vision.RunningMode # Create a gesture recognizer instance with the video mode: options = GestureRecognizerOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.VIDEO) with GestureRecognizer.create_from_options(options) as recognizer: # The detector is initialized. Use it here. # ...

Live stream

import mediapipe as mp BaseOptions = mp.tasks.BaseOptions GestureRecognizer = mp.tasks.vision.GestureRecognizer GestureRecognizerOptions = mp.tasks.vision.GestureRecognizerOptions GestureRecognizerResult = mp.tasks.vision.GestureRecognizerResult VisionRunningMode = mp.tasks.vision.RunningMode # Create a gesture recognizer instance with the live stream mode: def print_result(result: GestureRecognizerResult, output_image: mp.Image, timestamp_ms: int): print('gesture recognition result: {}'.format(result)) options = GestureRecognizerOptions( base_options=BaseOptions(model_asset_path='/path/to/model.task'), running_mode=VisionRunningMode.LIVE_STREAM, result_callback=print_result) with GestureRecognizer.create_from_options(options) as recognizer: # The detector is initialized. Use it here. # ...

Opsi konfigurasi

Tugas ini memiliki opsi konfigurasi berikut untuk aplikasi Python:

| Nama Opsi | Deskripsi | Rentang Nilai | Nilai Default | |

|---|---|---|---|---|

running_mode |

Menetapkan mode berjalan untuk tugas. Ada tiga

mode: GAMBAR: Mode untuk input gambar tunggal. VIDEO: Mode untuk frame video yang didekode. LIVE_STREAM: Mode untuk live stream data input, seperti dari kamera. Dalam mode ini, resultListener harus dipanggil untuk menyiapkan pemroses guna menerima hasil secara asinkron. |

{IMAGE, VIDEO, LIVE_STREAM} |

IMAGE |

|

num_hands |

Jumlah maksimum tangan dapat dideteksi oleh

GestureRecognizer.

|

Any integer > 0 |

1 |

|

min_hand_detection_confidence |

Skor keyakinan minimum agar deteksi tangan dianggap berhasil dalam model deteksi telapak tangan. | 0.0 - 1.0 |

0.5 |

|

min_hand_presence_confidence |

Skor keyakinan minimum dari skor kehadiran tangan dalam model deteksi penanda tangan. Dalam mode Video dan mode Live stream Pengenal Gestur, jika skor keyakinan kehadiran tangan dari model penanda tangan berada di bawah ambang batas ini, skor tersebut akan memicu model deteksi telapak tangan. Jika tidak, algoritma pelacakan tangan ringan akan digunakan untuk menentukan lokasi tangan untuk deteksi penanda berikutnya. | 0.0 - 1.0 |

0.5 |

|

min_tracking_confidence |

Skor keyakinan minimum agar pelacakan tangan dianggap berhasil. Ini adalah nilai minimum IoU kotak pembatas antara tangan dalam frame saat ini dan frame terakhir. Dalam mode Video dan mode Streaming Pengenal Gestur, jika pelacakan gagal, Pengenal Gestur akan memicu deteksi tangan. Jika tidak, deteksi tangan akan dilewati. | 0.0 - 1.0 |

0.5 |

|

canned_gestures_classifier_options |

Opsi untuk mengonfigurasi perilaku pengklasifikasi gestur standar. Gestur standar adalah ["None", "Closed_Fist", "Open_Palm", "Pointing_Up", "Thumb_Down", "Thumb_Up", "Victory", "ILoveYou"] |

|

|

|

custom_gestures_classifier_options |

Opsi untuk mengonfigurasi perilaku pengklasifikasi gestur kustom. |

|

|

|

result_callback |

Menetapkan pemroses hasil untuk menerima hasil klasifikasi secara asinkron saat pengenal gestur berada dalam mode live stream.

Hanya dapat digunakan jika mode berjalan disetel ke LIVE_STREAM |

ResultListener |

T/A | T/A |

Menyiapkan data

Siapkan input Anda sebagai file gambar atau array numpy, lalu konversikan ke

objek mediapipe.Image. Jika input Anda adalah file video atau live stream dari webcam, Anda dapat menggunakan library eksternal seperti OpenCV untuk memuat frame input sebagai array numpy.

Gambar

import mediapipe as mp # Load the input image from an image file. mp_image = mp.Image.create_from_file('/path/to/image') # Load the input image from a numpy array. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_image)

Video

import mediapipe as mp # Use OpenCV’s VideoCapture to load the input video. # Load the frame rate of the video using OpenCV’s CV_CAP_PROP_FPS # You’ll need it to calculate the timestamp for each frame. # Loop through each frame in the video using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Live stream

import mediapipe as mp # Use OpenCV’s VideoCapture to start capturing from the webcam. # Create a loop to read the latest frame from the camera using VideoCapture#read() # Convert the frame received from OpenCV to a MediaPipe’s Image object. mp_image = mp.Image(image_format=mp.ImageFormat.SRGB, data=numpy_frame_from_opencv)

Menjalankan tugas

Pengenal Gestur menggunakan fungsi recognize, recognize_for_video, dan recognize_async untuk memicu inferensi. Untuk pengenalan gestur, hal ini melibatkan prapemrosesan data input, mendeteksi tangan dalam gambar, mendeteksi penanda tangan, dan mengenali gestur tangan dari penanda.

Kode berikut menunjukkan cara menjalankan pemrosesan dengan model tugas.

Gambar

# Perform gesture recognition on the provided single image. # The gesture recognizer must be created with the image mode. gesture_recognition_result = recognizer.recognize(mp_image)

Video

# Perform gesture recognition on the provided single image. # The gesture recognizer must be created with the video mode. gesture_recognition_result = recognizer.recognize_for_video(mp_image, frame_timestamp_ms)

Live stream

# Send live image data to perform gesture recognition. # The results are accessible via the `result_callback` provided in # the `GestureRecognizerOptions` object. # The gesture recognizer must be created with the live stream mode. recognizer.recognize_async(mp_image, frame_timestamp_ms)

Perhatikan hal berikut:

- Saat berjalan dalam mode video atau mode live stream, Anda juga harus memberikan stempel waktu frame input ke tugas Pengenal Gestur.

- Saat berjalan dalam model gambar atau video, tugas Pengenal Gestur akan memblokir thread saat ini hingga selesai memproses gambar atau frame input.

- Saat berjalan dalam mode live stream, tugas Pengenal Gestur tidak memblokir thread saat ini, tetapi segera ditampilkan. Fungsi ini akan memanggil pemroses hasil dengan hasil pengenalan setiap kali selesai memproses frame input. Jika fungsi pengenalan dipanggil saat tugas Pengenal Gestur sibuk memproses frame lain, tugas akan mengabaikan frame input baru.

Untuk contoh lengkap menjalankan Pengenal Gestur pada gambar, lihat contoh kode untuk mengetahui detailnya.

Menangani dan menampilkan hasil

Pengenal Gestur menghasilkan objek hasil deteksi gestur untuk setiap pengenalan yang dijalankan. Objek hasil berisi penanda tangan dalam koordinat gambar, penanda tangan dalam koordinat dunia, tangan dominan(tangan kiri/kanan), dan kategori gestur tangan dari tangan yang terdeteksi.

Berikut adalah contoh data output dari tugas ini:

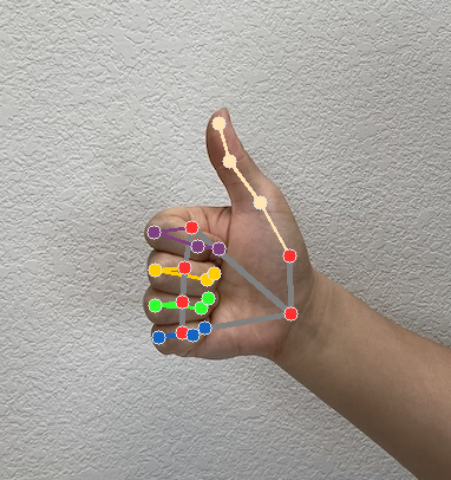

GestureRecognizerResult yang dihasilkan berisi empat komponen, dan setiap komponen adalah array, dengan setiap elemen berisi hasil deteksi dari satu tangan yang terdeteksi.

Tangan dominan

Kecenderungan tangan menunjukkan apakah tangan yang terdeteksi adalah tangan kiri atau kanan.

Gestur

Kategori gestur yang dikenali dari tangan yang terdeteksi.

Tempat terkenal

Ada 21 penanda tangan, masing-masing terdiri dari koordinat

x,y, danz. Koordinatxdanydinormalisasi ke [0,0, 1,0] berdasarkan lebar dan tinggi gambar. Koordinatzmewakili kedalaman penanda, dengan kedalaman di pergelangan tangan sebagai asal. Makin kecil nilainya, makin dekat penanda ke kamera. Besarzmenggunakan skala yang kira-kira sama denganx.Landmark Dunia

21 penanda tangan juga ditampilkan dalam koordinat dunia. Setiap penanda geografis terdiri dari

x,y, danz, yang mewakili koordinat 3D dunia nyata dalam meter dengan asal di pusat geometris tangan.

GestureRecognizerResult:

Handedness:

Categories #0:

index : 0

score : 0.98396

categoryName : Left

Gestures:

Categories #0:

score : 0.76893

categoryName : Thumb_Up

Landmarks:

Landmark #0:

x : 0.638852

y : 0.671197

z : -3.41E-7

Landmark #1:

x : 0.634599

y : 0.536441

z : -0.06984

... (21 landmarks for a hand)

WorldLandmarks:

Landmark #0:

x : 0.067485

y : 0.031084

z : 0.055223

Landmark #1:

x : 0.063209

y : -0.00382

z : 0.020920

... (21 world landmarks for a hand)

Gambar berikut menunjukkan visualisasi output tugas:

Kode contoh Pengenal Gestur menunjukkan cara menampilkan hasil pengenalan yang ditampilkan dari tugas, lihat contoh kode untuk mengetahui detailnya.